本指南深入解析PHP构建高效蜘蛛池的技术原理及实战方法,为用户提供从搭建到优化的全方位指导,助力高效爬虫项目实施。

本文目录导读:

随着互联网的快速发展,搜索引擎优化(SEO)成为网站运营的重要环节,蜘蛛池作为一种提高网站收录率和搜索引擎排名的有效手段,受到了许多网站管理员的青睐,PHP作为一种功能强大的服务器端脚本语言,在构建蜘蛛池方面具有得天独厚的优势,本文将为您解析PHP构建蜘蛛池的技术要点,并提供实战指南。

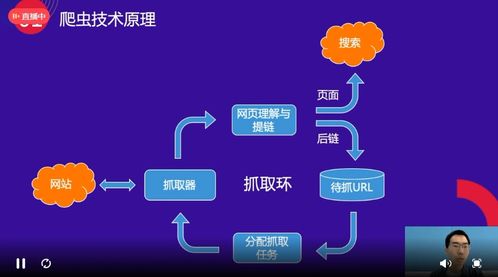

蜘蛛池,又称爬虫池,是一种利用程序模拟搜索引擎蜘蛛抓取网页内容的系统,通过构建蜘蛛池,网站管理员可以快速抓取大量网页,提高网站在搜索引擎中的收录率和排名,PHP因其易于学习和使用,成为构建蜘蛛池的热门语言。

1、网页抓取

网页抓取是蜘蛛池的核心功能,PHP可以通过多种方式实现网页抓取,如使用cURL库、file_get_contents函数等,以下是一个简单的PHP抓取网页的示例代码:

$url = "http://www.example.com"; $html = file_get_contents($url);

2、数据存储

抓取到的网页数据需要存储起来,以便后续处理,PHP可以借助MySQL、MongoDB等数据库存储数据,以下是一个使用MySQL存储网页数据的示例代码:

$mysqli = new mysqli("localhost", "username", "password", "database");

$sql = "INSERT INTO pages (url, content) VALUES (?, ?)";

$stmt = $mysqli->prepare($sql);

$stmt->bind_param("ss", $url, $html);

$stmt->execute();3、线程技术

为了提高抓取效率,可以使用PHP的线程技术,通过多线程同时抓取网页,可以大幅提升蜘蛛池的性能,以下是一个使用PHP线程的示例代码:

$threads = array();

for ($i = 0; $i < 10; $i++) {

$url = "http://www.example.com/page" . ($i + 1);

$thread = new Thread(function ($url) {

$html = file_get_contents($url);

// 处理网页数据

});

$thread->start($url);

$threads[] = $thread;

}

foreach ($threads as $thread) {

$thread->join();

}4、防止被封锁

为了避免被目标网站封锁,需要在抓取过程中遵守robots.txt规则,并设置合理的抓取频率,以下是一个简单的示例代码:

$userAgent = "Your User Agent";

$timeout = 10;

$cookie = "__cookie__";

$headers = array(

"User-Agent: " . $userAgent,

"Connection: Keep-Alive",

"Keep-Alive: timeout=" . $timeout . ", max=" . $timeout,

"Cookie: " . $cookie

);

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, $url);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, true);

curl_setopt($ch, CURLOPT_HTTPHEADER, $headers);

curl_setopt($ch, CURLOPT_TIMEOUT, $timeout);

$html = curl_exec($ch);

curl_close($ch);1、选择合适的PHP版本

建议使用较新版本的PHP,以确保拥有更多的功能和更好的性能。

2、安装必要的扩展库

根据需求安装cURL、MySQL等扩展库。

3、设计合理的抓取策略

根据目标网站的特点,设计合理的抓取策略,如抓取频率、深度等。

4、监控蜘蛛池运行状态

定期检查蜘蛛池的运行状态,确保其稳定运行。

5、优化代码

针对抓取到的网页数据,进行合理的处理和存储,提高蜘蛛池的性能。

PHP构建蜘蛛池具有操作简单、性能优越等特点,通过本文的解析,相信您已经掌握了PHP构建蜘蛛池的技术要点,在实际应用中,不断优化和调整蜘蛛池策略,以实现最佳效果,祝您在SEO道路上越走越远!